18. April 2025 von Hannah Fischer und Sina Barghidarian

Effiziente Textverarbeitung in der Versicherungsbranche

Open-Source Information Retrieval – eine datenschutzkonforme Alternative

Die Versicherungsbranche steht vor der Herausforderung, große Mengen an textbasierten Dokumenten wie Policen, Schadensmeldungen, Vertragsänderungen und Kundenkorrespondenz effizient zu verarbeiten. Diese oft unstrukturierten Dokumente erfordern eine zeitaufwändige manuelle Bearbeitung, die Ressourcen bindet. Technologien wie Large Language Models (LLMs) bieten hier neue Automatisierungsmöglichkeiten: Sie können Dokumente kategorisieren, Informationen extrahieren und relevante Daten in Prozesse integrieren. Das spart Kosten, steigert die Effizienz und minimiert Fehler.

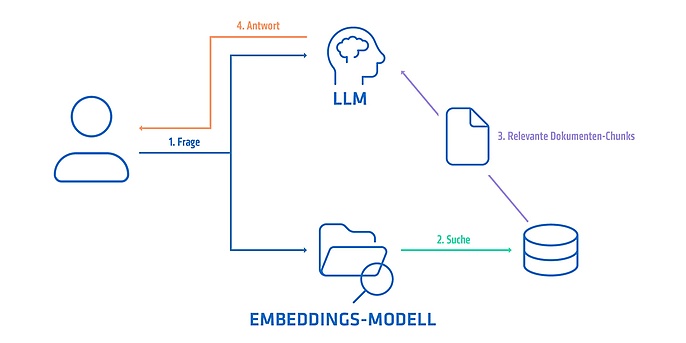

Ein wichtiger Anwendungsbereich von LLMs ist die Dokumentenbefragung, bei der inhaltliche Fragen zu Dokumenten mit einem Retrieval-Augmented-Generation-System (RAG-System) beantwortet werden. Häufig fehlt es dabei jedoch an einer objektiven Evaluierung der Antwortgenauigkeit. Zudem stellt sich die Frage, wie Modelle durch Fine-Tuning an branchenspezifische Anforderungen angepasst und bewertet werden können. Viele Lösungen basieren auf Systemen wie der GPT-Familie von OpenAI, die leistungsstark sind, jedoch je nach Anbieter und Implementierung unterschiedliche Datenschutzrisiken mit sich bringen können. Dabei entstehen Risiken, da Daten oft an externe Anbieter übermittelt werden, was insbesondere in der Versicherungsbranche mit sensiblen Kundendaten gegen Datenschutzgesetze wie die DSGVO (Datenschutz-Grundverordnung) verstoßen könnte.

Aus diesen Gründen haben wir uns damit auseinandergesetzt, wie wir ein RAG-System optimieren und eine Grundlage für Datenschutzkonformität schaffen können. In diesem Blog-Beitrag:

- Erklären wir das Konzept von RAG-Systemen

- Zeigen Optimierungs- und Fine-Tuning-Methoden auf

- Vergleichen das von uns gewählte Open-Source-Modell mit dem proprietären text-embedding-ada-002-Modell von OpenAI

- Beleuchten die Stärken und Potenziale von Open-Source-RAG-Systemen speziell für die Versicherungsbranche

RAG-Systeme zur Dokumentenbefragung: Eine Lösung für die Versicherungsbranche

RAG-Systeme kombinieren Sprachmodelle (LLMs) mit Retrieval-Methoden: Der Retriever durchsucht Dokumente nach relevanten Passagen, die das Sprachmodell verarbeitet. Diese Systeme sind ideal für Dokumentenbefragungen in der Versicherungsbranche, bei denen gezielt Fragen zu Dokumenten gestellt und automatisch beantwortet werden. Für unser optimiertes RAG-System ermittelten wir das optimale Retriever-Modell durch Vergleichstests.

Für die Entwicklung und das Testen unseres RAG-Systems verwendeten wir einen Datensatz, der in seiner Struktur und seinem Inhalt den Versicherungsdokumenten sehr ähnlich ist. Die Dokumente stammen aus dem „Dienstleistungsfinder“ der Stadtverwaltung München. Dort werden Informationen über die von der Stadt angebotenen Dienstleistungen online präsentiert. Die Informationen reichen von der Beantragung eines Personalausweises bis zur Müllentsorgung. Ähnlich wie Versicherungsdokumente handelt es sich bei diesen Dokumenten um Texte mit deutscher, formeller Sprache. Zudem enthalten diese Dokumente branchenspezifisches Wissen, das über das allgemeine Sprachmodellwissen hinausgeht. Passend zu dem Datensatz gibt es auch noch einen Frage-Antwort-Datensatz (QA-Datensatz). Dieser beinhaltet Fragen und passende Antworten zu den Dokumenten. Der QA-Datensatz bietet eine passende Grundlage, um die Modelle zu evaluieren.

Unser Fokus lag darauf, den Retriever zu optimieren, da er die Basis für die Genauigkeit des gesamten Systems bildet. Die Ergebnisse unserer Tests zeigen, dass gezieltes Fine-Tuning eine erhebliche Leistungssteigerung ermöglicht. Wie wir dabei vorgegangen sind, beschreiben wir im nächsten Abschnitt. Unser RAG-System ist eine effiziente Alternative zu proprietären Lösungen mit Datenschutzrisiken. Mit einem Open-Source-Modell konnten wir eine kosteneffiziente Lösung gestalten und die Grundlage für ein Datenschutz konformes System ermöglichen, da Unternehmen die Datenverarbeitung vollständig intern kontrollieren können. Dies wird durch self-hosting auf unternehmenseigenen Servern, den Verzicht auf externe APIs und die Möglichkeit zur vollständigen Datenlöschung sichergestellt.

Optimierung eines RAG-Systems: Unsere Methodik

In mehreren Schritten haben wir systematisch die Genauigkeit des Systems optimiert. Um die Wirksamkeit jeder einzelnen Optimierung zu messen, nutzten wir einen Frage-Antwort-Datensatz zur Evaluation. Dieser Datensatz enthält realitätsnahe Fragen, die auf die Inhalte der genutzten Dokumente abgestimmt sind. Die Genauigkeit (Accuracy) wurde als zentrale Metrik verwendet, wobei wir überprüften, wie viele der generierten Antworten korrekt mit den tatsächlichen, im Datensatz definierten Antworten übereinstimmten.

Dieses Evaluationsverfahren diente dazu, die Ergebnisse jedes Schrittes objektiv zu bewerten und die Fortschritte bei der Optimierung des Retrievers zu quantifizieren. Die Ergebnisse der Hyperparameter-Optimierung, des Fine-Tunings und des Vergleichs mit proprietären Modellen basieren auf dieser methodischen Herangehensweise.

Schritt 1: Hyperparameter-Optimierung

Zunächst begannen wir mit der Hyperparameter-Optimierung, bei der vorab festgelegte Parameter eines Modells angepasst werden, um dessen Leistung zu maximieren – ohne zusätzliches Training. Im Gegensatz zum klassischen Training, bei dem das Modell aus den Daten lernt, zielt das Hyperparameter-Tuning darauf ab, die Parameter so zu modifizieren, dass das Modell optimal an die Anforderungen angepasst wird.

Für diesen Prozess wählten wir ein vortrainiertes Open-Source-Embeddings-Modell als Retriever, basierend auf RoBERTa und optimiert für die deutsche Sprache. Wir experimentierten mit:

- Chunksize und Overlap: Beeinflussen, wie Dokumente in kleinere Abschnitte zerlegt werden.

- Parameter k: Bestimmt die Anzahl der Treffer, die der Retriever pro Anfrage zurückgibt.

- Splitting-Strategien: Effiziente Methoden zur Dokumentenzersetzung.

Ergebnis: Durch gezielte Anpassungen erzielten wir eine Verbesserung der Accuracy von 68 Prozent auf 86 Prozent, was die Wirksamkeit der Hyperparameter-Optimierung belegt. Dies zeigt, dass bereits ohne zusätzliches Training und durch die Auswahl des richtigen Open-Source-Modells und die Anpassung der Hyperparameter bemerkenswerte Ergebnisse erzielt werden können.

GenAI Studie Insurance

So nutzten und bewerten Versicherungen ChatGPT & GenAI

Wir haben für Sie Antworten auf die Fragen zusammengestellt, die sich der Versicherungs-Sektor heute stellt: von der Suche nach Anwendungsmöglichkeiten über die Entwicklung von GenAI-Anwendungen bis hin zur Implementierung in die eigenen Prozesse. Unser Dossier gibt Ihnen auf 33 Seiten die Informationen, die Sie brauchen.

Schritt 2: Fine-Tuning des Retrievers

Nachdem wir dargestellt haben, wie allein durch Hyperparameter-Optimierung eine hohe Genauigkeit erreicht werden kann, haben wir im nächsten Schritt untersucht, wie Fine-Tuning die Leistung weiter verbessert. Fine-Tuning bezeichnet den Prozess, bei dem ein vortrainiertes Modell mit zusätzlichen spezifischen Daten weitertrainiert wird, um es besser auf die Anforderungen einer bestimmten Aufgabe oder Domäne anzupassen. Dabei gibt es verschiedene Techniken, wie zum Beispiel das Masked Language Modeling (MLM) oder Contrastive Learning, die jeweils unterschiedliche Ansätze zur Verbesserung der Modellleistung verfolgen.

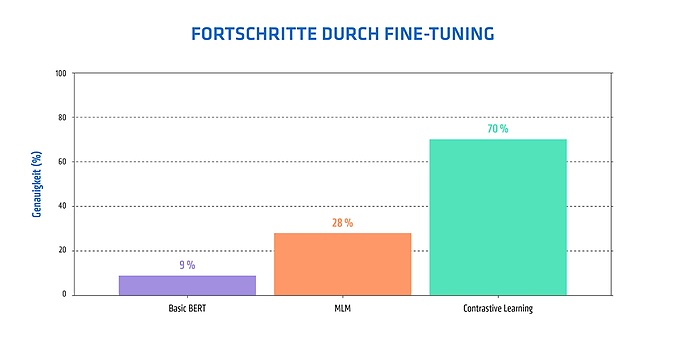

Dabei setzten wir ein kleines, allgemeines BERT-Modell mit nur 100M Parametern ein, das anfänglich nur eine Accuracy von 8 Prozent erreichte. Hierbei kamen zwei unterschiedliche Ansätze zum Einsatz:

1. Masked Language Model (MLM)-Training

Beim MLM-Training wird das Modell trainiert, bestimmte Wörter in einem Satz zu maskieren und die Lücken richtig zu füllen. Dies hilft dem Modell, den spezifischen Wortschatz und die Fachterminologie der Versicherungsbranche besser zu verstehen. Wir nutzten 1.000 zufällige Sätze aus den Dokumenten.

Ergebnis: Die Accuracy stieg von anfänglichen 8 Prozent auf 28 Prozent. Das zeigt, dass MLM-Training den Wortschatz verbessert, aber keinen signifikanten Einfluss auf die Retrieval-Genauigkeit hat.

2. Contrastive Learning

Contrastive Learning trainiert das Modell, ähnliche Paare von Fragen und Kontexten zusammenzubringen und unähnliche zu trennen. Hierbei wurden Fragen-Kontext-Paare aus einem QA-Datensatz mit der MultipleNegativesRankingLoss-Funktion genutzt, um das Modell zu trainieren. Es standen dazu 1700 Frage-Antwort-Paare zur Verfügung.

Ergebnis: Die Accuracy stieg auf beeindruckende 70 Prozent, was die Wirksamkeit von kontrastivem Lernen für Retrieval-Aufgaben verdeutlicht.

Zusätzlich wurde das RoBERTa-Modell aus Schritt 1 nachjustiert. Da dieses Modell jedoch größer ist und mit 400M Parametern mehr Trainingsdaten benötigt, erreichte es nach dem Fine-Tuning eine Accuracy von 85 Prozent. Insgesamt zeigt sich, dass Modelle durch Fine-Tuning gut auf spezifische Daten abgestimmt werden können, auch wenn sie vorher keine Erfahrung in der jeweiligen Domäne hatten. Wie viele Daten dafür benötigt werden, hängt vor allem von der Größe des Modells ab, was es ermöglicht, die Anpassung flexibel an verschiedene Bedürfnisse anzupassen.

Schritt 3: Vergleich mit proprietären Modellen

Abschließend verglichen wir unser Open-Source-Modell mit dem proprietären text-embedding-ada-002-Modell von OpenAI. Im Folgendem wird es als das Ada-Modell bezeichnet. Proprietäre Modelle wie das Ada-Modell werden vollständig vom Anbieter kontrolliert, was Nutzerinnen und Nutzer von dessen Infrastruktur und Preisgestaltung abhängig macht und Flexibilität und Kostenstruktur einschränken kann. Open-Source-Modelle, wie das von uns genutzte, bieten hingegen mehr Kontrolle und je nach Anbieter mehr Anpassungsfähigkeit, da sie selbst gehostet und modifiziert werden können. Unser Modell ist zudem kleiner als Ada. Das Ada-Modell wurde auf viele Sprachen trainiert und hat eine größere Kontextlänge als unser Modell. Unser Modell wurde ausschließlich auf die deutsche Sprache trainiert und kann weniger Wörter auf einmal verarbeiten.

Trotz der geringeren Größe erzielt unser Modell eine vergleichbare Leistung und kann kostengünstig auf eigener Hardware betrieben werden. In unseren Tests wurden beide Modelle auf den QA-Datensatz getestet und die Accuracy berechnet. Dabei erreichte das Ada-Modell eine Genauigkeit von 90 Prozent, während unser Open-Source-Modell 86 Prozent erzielte. Die etwas höhere Genauigkeit des Ada-Modells könnte auf seine umfangreichere Trainingsdatenmenge, die Unterstützung mehrerer Sprachen und die größere Kontextlänge zurückzuführen sein. Dennoch bietet unser Open-Source-Ansatz entscheidende Vorteile:

- Ansatz für DSGVO-Konformität: Daten bleiben unter eigener Kontrolle.

- Kontrolle über den Entwicklungsprozess: Anpassung an spezifische Anforderungen.

- Kosteneffizienz: Geringere Betriebskosten durch Hosting auf eigener Infrastruktur.

Diese Vorteile machen Open-Source-Modelle zu einer attraktiven Alternative für den Einsatz in der Versicherungsbranche.

LLM in der Versicherungsbranche

Wie Anwednungsfälle der disruptiven Technik die Branche verändern

Language Models stehen derzeit im Mittelpunkt eines Hypes. Mit dem Aufkommen von GPT-3, GPT-4 und anderen fortschrittlichen Modellen haben sie eine enorme Aufmerksamkeit auf sich gezogen. Die Fähigkeit dieser leistungsstarken KI-Systeme, natürliche Sprache zu verstehen und menschenähnlichen Texte zu generieren, hat große Begeisterung in verschiedenen Branchen hervorgerufen, einschließlich der Versicherungsbranche.

Open-Source RAG-Systeme: Die Zukunft der Textverarbeitung in der Versicherungsbranche

Unsere Arbeit belegt, dass Open-Source-RAG-Systeme eine leistungsstarke und zukunftsweisende Alternative zu proprietären Lösungen darstellen, insbesondere für datensensitive Branchen wie die Versicherungswirtschaft. Die Testergebnisse zeigen, dass durch gezielte Hyperparameter-Optimierung bereits eine Verbesserung der Accuracy erzielt werden kann, während Fine-Tuning selbst kleinere Modelle mit begrenzten Datensätzen signifikant verbessert.

Größere Modelle wie RoBERTa profitieren hingegen besonders stark von umfangreichen und hochwertigen Daten, was ihre Leistungsfähigkeit für spezialisierte Aufgaben weiter steigert. Dieser Ansatz kombiniert maximale Flexibilität mit einer Strategie zu DSGVO-Konformität, wodurch Unternehmen die volle Kontrolle über ihre Daten und den Entwicklungsprozess behalten. Allerdings erfordern Open-Source-Lösungen oft einen höheren Wartungsaufwand und technische Expertise, um eine reibungslose Implementierung und kontinuierliche Optimierung sicherzustellen.

Open-Source RAG-Systeme ermöglichen es Versicherungsunternehmen, kosteneffizient undflexibel mit Daten umzugehen und bieten einen Lösungsweg zur DSGVO-Konformität. Sie bieten vergleichbare Leistung zu proprietären Systemen und reduzieren gleichzeitig Abhängigkeiten und Datenschutzrisiken.

Außerdem interessant